共计 443 个字符,预计需要花费 2 分钟才能阅读完成。

:mrgreen:博主今天跑完微马拉松,回来之后躺在沙发上就睡着了,醒来洗个澡开始学习了,网易云课堂的视频最近也在看,今天来说下几个激活函数吧,在没有深度学习之前基本上常用的就是sigmoid函数,主要还是在lr中用到的比较多。

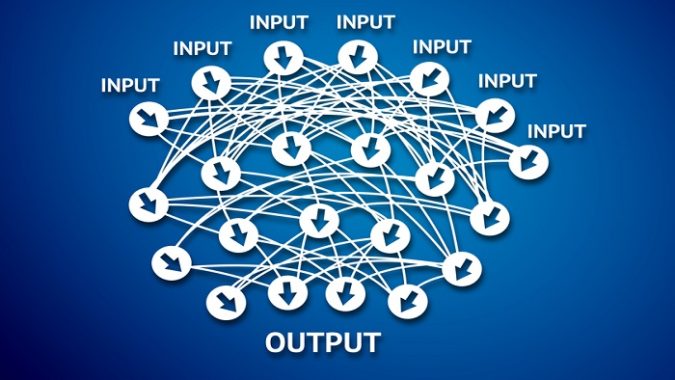

在吴恩达的DeepLearning视频中给出了四个激活函数,分别是sigmoid,tanh和relu leakyrelu。

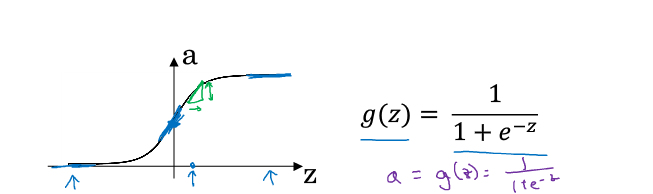

sigmoid函数

导数的特性就是

\[ g'(z)=g(z)(1-g(z)) \]

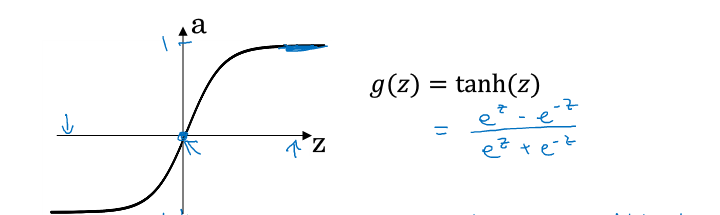

tanh函数

导数的特性

\[ g'(z)=1-g(z)^2 \]

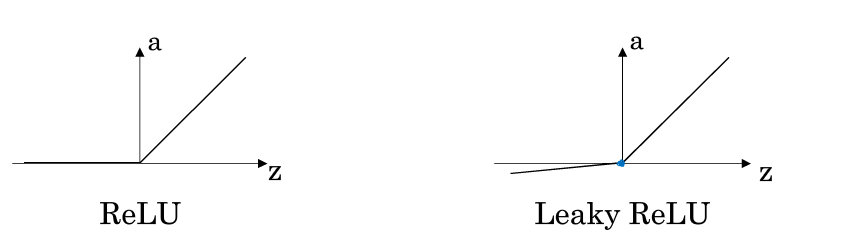

relu函数和leakyrelu

relu函数在z>0时的导数都是为1,其余为0,所以在反向传播的时候会出现梯度消失的情况。leaky relu就是在z<0的时候设置一个很小的斜率,参数可以设置0.01等类似参数,这样你得到的导数不会是0。

一般情况下relu函数的效果较好,sigmoid会一般会用在输出层的激活函数中,在隐含层relu函数用的比较多,sigmoid会出现梯度消失的情况,消失的原因是链式求导

正文完

请博主喝杯咖啡吧!